Concepciones semánticas de la información

Luciano Floridi

University of Oxford

Versión española de Semantic Conceptions of Information, de la Stanford Encyclopedia of Philosophy.

Traducción: Cristian López

“Amo la información por sobre todos los temas que se cruzan en mi camino y, especialmente, por sobre aquellos que son más importantes”. Así declara con firmeza Eufranor, uno de los defensores de la fe cristiana en el Alcifrón de Berkeley (Diálogo 1, Sección 5, Párrafos 6/10, ver Berkeley 1732). Evidentemente, la información ha sido objeto de deseo filosófico desde hace mucho tiempo, desde mucho antes de la revolución de la computación, del internet o del pandemonio del “dot.com” (ver, por ejemplo, Dunn 2001 y Adams 2003). Sin embargo, ¿qué es exactamente lo que Eufranor ama? ¿Qué es la información? La pregunta ha recibido muchas respuestas en diferentes campos pero, como era de esperar, los diversos estudios no concuerdan en una definición simple y única de la información (ver, por ejemplo, Braman 1989, Losee 1997, Machlup y Mansfield 1983, Debons y Cameron 1975, Larson y Debons 1983).

La información es, de una manera particular, un fenómeno polimórfico y un concepto polisemántico. En tanto explicandum, puede estar asociado a muchas explicaciones, dependiendo del nivel de abstracción que se adopte, y del cúmulo de requisitos y expectativas que orientan una teoría. Al leer este artículo, el lector quizá debería recordar este rasgo notorio de la información, ya que serán inevitables algunas simplificaciones esquemáticas y ciertas decisiones interpretativas. El propio Claude E. Shannon fue muy precavido al respecto:

“La palabra ‘información’ ha recibido diferentes significados por parte de varios autores en el campo general de la teoría de la información. Probablemente, un buen número de ellos serán suficientemente útiles en ciertas aplicaciones y merezcan un estudio posterior y un reconocimiento permanente. Difícilmente se podría esperar que un simple concepto de información pudiera dar cuenta, de manera satisfactoria, de las numerosas aplicaciones posibles de este campo general” (cursivas agregadas) (Shannon 1993, 180).

En concordancia con Shannon, Weaver (1949) propuso un análisis tripartito de la información en términos de:

(1) problemas técnicos que conciernen a la cuantificación de la información y que son abordados por la Teoría de Shannon.

(2) problemas semánticos relacionados con el significado y la verdad; y

(3) lo que Weaver llamó problemas “de influencia” vinculados con el impacto y la efectividad de la información en el comportamiento humano, los cuales, deberían jugar de acuerdo con él un papel igualmente importante.

Y estos son sólo unos cuantos de los primeros problemas que surgieron en el análisis de la información.

De hecho, el exceso en la cantidad de los análisis existentes puede resultar confuso. Con frecuencia se ventilan quejas relacionadas con malos entendidos e usos inadecuados del concepto mismo de información, incluso cuando tales quejas no parecen aportar beneficio alguno. Por ejemplo, Sayre (1976) criticó la “laxitud en el uso del término ‘información’” en Armstrong (1968) (ahora ver Armstrong 1993) y en Dennett (1969) (ahora ver Dennett 1986), a pesar de su aprecio por otros numerosos aspectos de sus trabajos. Recientemente, Harms señaló confusiones similares en Chalmers (1996), quien

“parece pensar que la noción teórica de la información (ver mi agregado, en la Sección 3) trata acerca de los posibles estados que existen y de cómo ellos están relacionados o estructurados, y no acerca de cómo las probabilidades se distribuyen entre ellos” (Harms 1998, 480).

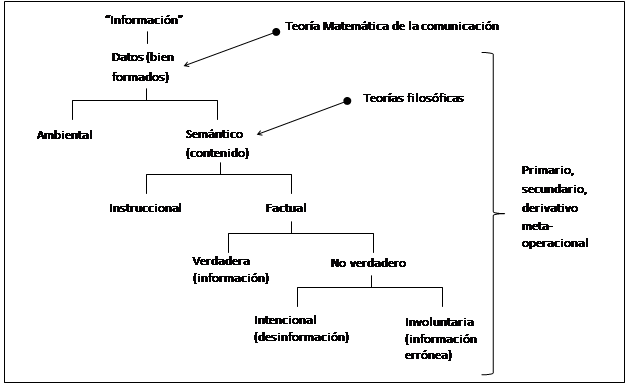

Para evitar este tipo de dificultades, el presente artículo ha sido organizado en cuatro secciones. La Sección 1 esboza un mapa de los principales sentidos en los que se puede hablar de información semántica, basándonos en el análisis del concepto de data (representado en la Figura 1, ver más adelante). A veces, los numerosos conceptos de información que están organizados en el mapa pueden agruparse de distintas maneras. Sin embargo, esto no debería considerarse necesariamente un signo de confusión, ya que para algunos filósofos esto puede ser el resultado de un vínculo intencional. El mapa no pretende ser exhaustivo, sino que busca meramente evitar algunos escollos y demarcar los alcances de este artículo, que de otra manera podría convertirse con facilidad en una versión resumida de la Encyclopedia Britannica. Su carácter esquemático es tan sólo un punto de partida para futuras investigaciones y el lector interesado en profundizar su conocimiento al respecto puede consultar Floridi (2011) y Adriaans y van Benthem (2008).

Luego de esta orientación inicial, en la Sección 2 se expone una breve introducción a la teoría de la información, es decir, a la teoría matemática de la comunicación (TMC), La TMC merece tener un espacio propio ya que es el enfoque cuantitativo que ha ejercido mayor influencia entre los filósofos. Esta sección proveerá el trasfondo necesario para entender muchas de las teorías semánticas de la información contemporáneas, especialmente los trabajos de Bar-Hillel y Carnap (1953), y Dretske (1981).

En la Sección 3, se analiza la información como contenido semántico. La Sección 4 está abocada a focalizar en las investigaciones filosóficas acerca de la información semántica, aquello que Eufranor realmente ama.

Se advierte al lector que se utilizará una descripción de la información semántica en tanto dato significativo como criterio para delinear otros enfoques. Desafortunadamente, incluso una aproximación tan minimalista como esta se encuentra sujeta a desacuerdos; aunque, como punto a favor, se puede decir que es menos controversial que otras aproximaciones. Claramente, un análisis conceptual debe tener un punto de partida, lo cual, a menudo, significa adoptar alguna definición provisoria del objeto a investigar. Sin embargo, esta manera habitual de proceder no es lo que aquí se quiere enfatizar, ya que la dificultad resulta más abrumadora. El trabajo filosófico sobre el concepto de información (semántica) todavía se encuentra en ese lamentable estadio, en el cual las discrepancias cuestionan incluso la manera en la que los problemas mismos son provisionalmente formulados y enmarcados. Por ejemplo, todavía no disponemos de nada que sea comparable a la naturaleza bien pulida del problema de Gettier. En este sentido el señalamiento “usted se encuentra aquí” que se ofrece en este artículo podría muy bien ser puesto en otro lugar por otros filósofos. El propósito de esta entrada es ubicar el concepto de información semántica de manera firme en el mapa filosófico, lo que permitirá posibles ajustes futuros.

1 Un mapa informacional ↑

La información es un laberinto conceptual y en esta sección comenzaremos dando un vistazo a un mapa general de una de sus regiones con el propósito de abocarnos completamente al área semántica. La Figura 1 resume las principales distinciones que vamos a presentar.

Claramente, pasar a través de los diversos puntos en el mapa hará que el recorrido no sea lineal. La utilización de algunos ejemplos básicos, que permitirán ilustrar los pasos menos obvios, será de ayuda para mantener nuestro rumbo. Dicho esto, permítanme presentarles uno de los puntos al cual retornaremos recurrentemente.

1.1 Un ejemplo cotidiano de información. ↑

Es lunes por la mañana. Usted da arranque a su automóvil, pero no sucede nada: el motor no emite ni un sólo sonido y su silencio le preocupa. Como era de esperar, usted advierte que la luz roja de la batería está parpadeando, lo cual indica que la batería está descargada. Después de un par de intentos, se da por vencida y llama al mecánico. Le explica que su esposo olvidó apagar las luces del auto anoche –lo cual no es verdad, porque usted lo olvidó, pero está avergonzada y no quiere confesarlo – y ahora la batería está agotada. El mecánico le dice que el manual de instrucciones de su auto explica cómo utilizar cables de arranque para encender el motor. Afortunadamente, su vecino tiene todo lo que usted necesita. Lee el manual, mira los dibujos, sigue las instrucciones, soluciona el problema y finalmente conduce a la oficina.

Esta situación cotidiana será nuestra “mosca de la fruta”. Aunque es simple e intuitiva, provee los detalles suficientes para ilustrar las múltiples maneras en las cuales entendemos uno de nuestros recursos más importantes: la información.

1.2 La definición basada en datos de la información ↑

Es común pensar que la información está constituida por datos. Esto ciertamente ayuda, pero sólo de manera limitada. Desafortunadamente, la naturaleza de los datos no está filosóficamente bien entendida, a pesar de que algunos de los más importantes debates del pasado –tal como el debate acerca de los datos dados y acerca de los datos de los sentidos– han provisto al menos algunas ideas iniciales. De todas maneras, el concepto tiene la ventaja de ser menos rico, menos oscuro y menos esquivo que el de información, lo cual lo hace más fácil de manejar. Por lo tanto, comenzar por una definición de información basada en datos parece ser un buen punto de partida.

En las últimas tres décadas, diversos análisis en Ciencia de la Información, en Teoría, Metodología, Análisis y Diseño de Sistemas de Información, en Administración de Información (Sistemas), en Diseño de Base de Datos y en Teoría de la Decisión han adoptado una Definición General de Información (DGI) en términos de datos + significado. La DGI se ha vuelto un estándar operacional, especialmente en aquellos campos donde los datos y la información son tratados como entidades reificadas (considérese, por ejemplo, las modernas expresiones “extracción de datos” [data mining] y “administración de información” [information management]). Recientemente, la DGI ha empezado a ejercer influencia en la filosofía de la computación y la información (Floridi 1999 y Mingers 1997).

Una manera clara de formular la DGI es mediante una definición que consta de tres partes:

La Definición General de Información (DGI):

σ es una instancia de información, entendida en términos de contenido semántico, si y sólo si:

(DGI.1) σ consiste en uno o más datos;

(DGI.2) los datos en σ están bien formados;

(DGI.3) los datos bien formados en σ son significativos;

La DGI requiere una definición de “datos”, la cual se brindará en la siguiente sección. Pero antes haremos un breve comentario de cada cláusula.

De acuerdo con (DGI.1), los datos son la materia que constituye la información. Veremos que, rápidamente, las cosas pueden volverse más complicadas.

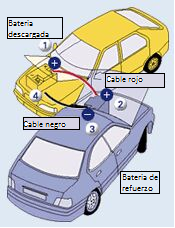

En (DGI.2), “bien formado” significa que los datos son cúmulos agrupados de manera adecuada, siguiendo reglas (sintaxis) que gobiernan el sistema escogido, el código o el lenguaje que se está analizando. En este punto, la sintaxis debe ser entendida en un sentido amplio (no solamente lingüístico), es decir, como aquello que determina la forma, la construcción, la composición o la estructura de algo (ingenieros, directores de películas, pintores, ajedrecistas y jardineros hablan de sintaxis en este sentido amplio). Por ejemplo, el manual de su auto puede mostrar (Figura 2), un dibujo bidimensional de dos autos ubicados uno al lado del otro, no uno encima del otro.

Esta sintaxis pictórica (que incluye la perspectiva lineal que representa el espacio por convergencia de líneas paralelas) hace que las ilustraciones sean potencialmente significativas para el usuario. Utilizando el mismo ejemplo, la batería necesita estar conectada al motor de la manera adecuada para funcionar: esto también es sintaxis, en términos de la adecuada arquitectura física de un sistema (por lo tanto, una batería desconectada es un problema sintáctico). Y, por supuesto, la conversación que usted sostiene con su vecino sigue las reglas gramaticales del español: esto es sintaxis en el sentido lingüístico habitual.

La semántica finalmente aparece en la cláusula (DGI.3). Que los datos sean “significativos” alude a que los datos deben cumplir con los significados (semánticos) del sistema escogido, del código o lenguaje en cuestión. De todas maneras, no olvidemos que la información semántica no es necesariamente algo de índole lingüística. Por ejemplo, cuando consideramos el caso del manual del auto donde las ilustraciones son visualmente significativas para el lector.

1.3 Una definición de datos ↑

De acuerdo con la DGI, la información no puede no tener datos. En el caso más sencillo, la información consiste en un único dato. Pero así, un dato se reduce solamente a una falta de uniformidad (diaphora es el término griego para “diferencia”), entonces una definición general de dato establece que:

La Definición Diaphorica de Datos (DDD):

Un dato es un hecho putativo que considera alguna diferencia o pérdida de uniformidad en algún contexto.

Dependiendo de las inclinaciones filosóficas, la DDD puede aplicarse en tres niveles:

- Datos como diaphora de re, es decir, como falta de uniformidad en el mundo real externo. No existe un nombre específico para “datos en la naturaleza”, pero una sugerencia sería referirnos a ellos como dedomena (“datos” en griego; nótese que nuestra palabra para “datos” proviene de la traducción latina de un trabajo de Euclides, Dedomena). Los dedomena no deben confundirse con datos ambientales (ver la sección 1.7.1). Ellos son datos puros o datos proto-epistémicos, es decir, datos que todavía no han sido interpretados epistémicamente. Como “fracturas en los tejidos del ser”, ellos sólo pueden ser considerados como un ancla externa de nuestra información, ya que no se puede acceder a ellos o los mismos no pueden ser elaborados sin un cierto nivel de abstracción (veremos más acerca de esto en la sección 3.2.2). Los dedomena pueden reconstruirse como requerimientos ontológicos, como el noúmeno en Kant o la sustancia en Locke: no tenemos experiencia epistémica de ellos sino que su presencia es inferida a partir de la experiencia o bien es requerida por ella. Por supuesto, no podemos ofrecer ningún ejemplo de esto, pero los dedomena son cualquier falta de uniformidad en el mundo que sea fuente de datos (lo que los sistemas de información como nosotros percibimos como datos); e.g., una luz roja en un fondo oscuro. Nótese que el punto aquí no es argumentar a favor de la existencia de datos puros en la naturaleza, sino proveer una distinción que (en la sección 1.6) nos ayudará a clarificar por qué algunos filósofos han aceptado la tesis de que no puede haber información sin representación de datos mientras que han rechazado la tesis que la información requiere una implementación física.

- Datos como diaphora de signo, es decir, falta de uniformidad entre (la percepción de) por lo menos dos estados físicos, tales como una carga completa de batería o una batería descargada, una señal eléctrica variable en una conversación telefónica, o el punto y la línea en el alfabeto Morse.

- Datos como diaphora de dicto, esto es, falta de uniformidad entre dos símbolos, por ejemplo, las letras A y B en el alfabeto latino.

Dependiendo de qué posición se adopte con respecto a la tesis de la neutralidad ontológica (sección 1.6) y de la naturaleza de la información ambiental (1.7.1) los dedomena en (1) pueden ser o bien idénticos con las señales en (2) o bien aquello que las hace posibles. A su vez, las señales en (2) son las que hacen posible los códigos de símbolos en (3).

El hecho de que la información dependa de que haya datos sintácticamente bien formados, y de la existencia de diferencias implementadas físicamente de diferentes maneras, explica por qué la información puede tan fácilmente disociarse de su soporte. El formato, medio y lenguaje en el cual la información semántica está codificada de hecho es, a menudo, irrelevante y, por lo tanto, no es considerado. En particular, la misma información semántica puede ser analógica o digital, estar impresa en un papel o puede visualizarse en una pantalla, puede estar en español o en algún otro idioma, expresada por medio de palabras o mediante dibujos. Las interpretaciones de esta independencia del soporte pueden variar radicalmente. La DDD deja indeterminados:

- la clasificación de los correlatos (neutralidad taxonómica);

- el tipo lógico al cual los correlatos pertenecen (neutralidad tipológica);

- la clase de soporte requerido para la implementación de su desigualdad (neutralidad ontológica); y

- la dependencia de su semántica de un productor (neutralidad genética).

Ahora veamos cada una de estas formas de neutralidad.

1.4 Neutralidad taxonómica ↑

Por lo general, un dato se clasifica como una entidad que exhibe una anomalía, usualmente porque una anomalía es perceptualmente más conspicua o menos redundante que las condiciones de fondo. Sin embargo, la relación de desigualdad es binaria y simétrica. Una hoja blanca de papel no es sólo la condición de fondo necesaria para la ocurrencia de un punto negro como dato, sino que es una parte constitutiva del dato mismo [punto-negro-en-papel-blanco], junto con la relación fundamental de desigualdad que lo empareja con el punto. Nada parece ser un dato per se. Más bien, ser un dato es una propiedad externa. Entonces, la DGI respalda la siguiente tesis de la neutralidad taxonómica:

Neutralidad taxonómica (NTa):

Un dato es una entidad relacional.

El slogan dice “los datos son correlatos”, pero la DGI es neutral con respecto a la identificación de los datos con correlatos específicos. En nuestro ejemplo, la DGI se abstiene de identificar como datos a la luz roja o al fondo blanco. Para entender por qué no puede haber “información sin datos”, examinaremos la neutralidad tipológica de la DGI.

1.5 Neutralidad tipológica ↑

La DGI también apoya la tesis de la neutralidad tipológica:

Neutralidad tipológica (NTi):

La información puede consistir en diferentes tipos de datos como correlatos.

Hay cinco clasificaciones que son bastante comunes, aunque todavía la terminología no está establecida o estandarizada. Estas clasificaciones no son mutuamente excluyentes y no deben ser entendidas como rígidas. Dependiendo de las circunstancias, de la clase de análisis que se esté llevando a cabo y del nivel de abstracción que se adopte, los mismos datos pueden caer en distintas clasificaciones.

(D1) Datos primarios. Son los principales datos almacenados en, por ejemplo, una base de datos, como una simple colección de números. Estos son los datos que generalmente son transmitidos por un sistema de manejo de la información, como por ejemplo el que es utilizado en un auto para indicar que la batería se está agotando. Normalmente, cuando se habla de datos, y de la información que ellos constituyen, implícitamente se asume que se trata de la información y de los datos primarios. Entonces, por defecto se asume que la luz roja del indicador de batería baja es una instancia de dato primario transmitiendo información primaria.

(D2) Datos secundarios. Los datos secundarios son opuestos a los datos primarios, consisten en su ausencia (por lo que podemos llamarlos también “anti-datos”). Recordemos cómo fue que supusimos, primariamente, que la batería estaba agotada: el motor no hizo el ruido usual. Del mismo modo, en Estrella de plata, Sherlock Holmes resuelve el caso al notar algo que nadie más había notado: el silencio inusual del perro. Claramente, el silencio puede ser muy informativo. Esta es una peculiaridad de la información, a saber, su ausencia puede también ser informativa. A esto podemos referirnos, entonces, como información secundaria.

(D3) Metadatos. Son indicaciones acerca de la naturaleza de otros datos (usualmente, primarios). Estos metadatos describen propiedades como ubicación, formato, actualización, disponibilidad, restricciones de uso, entre otras. De modo correspondiente, la metainformación es información acerca de la naturaleza de la información. Un ejemplo de metainformación simple puede ser “‘La batería está agotada’ está codificado en castellano”.

(D4) Datos operacionales. Son datos acerca de las operaciones del sistema de datos y de su desempeño. En correspondencia, la información operacional es información acerca de la dinámica de un sistema de información. Supongamos que el auto cuenta con una luz amarilla que cuando se enciende indica que el sistema de chequeo del auto está fallando. El hecho de que la luz esté encendida puede indicar que el indicador de la batería no esté funcionando adecuadamente y puede, por lo tanto, debilitar la hipótesis de que la batería esté agotada.

(D5) Datos derivativos. Pueden ser extraídos a partir de ciertos datos cuando estos últimos son usados como fuentes indirectas en la búsqueda de patrones, indicios o evidencias inferenciales acerca de cosas distintas de aquéllas directamente aludidas por los datos mismos, por ejemplo, para análisis comparativos y cuantitativos (ideometría). Esta categoría es difícil de definir con precisión, de modo que un ejemplo cotidiano puede resultar útil para ilustrar el punto. Las tarjetas de crédito dejan, notoriamente, un rastro de información derivativa. A partir del resumen de la tarjeta de crédito de una persona donde consta, por ejemplo, una compra de combustible en una gasolinera, uno puede derivar información acerca de su paradero en determinado momento. La información derivativa no es algo nuevo. Hume ofrece un bello ejemplo en estos tiempos de calentamiento global. En el Essays Moral, Political, and Literary (Part II, Essay 11. Of the Populousness of Ancient Nations, Parágrafos 155/186 mp. 448 gp. 432, ver Hume 1987), Hume reporta que “Es una observación de L'Abbe du Bos que Italia es más cálida en el presente que en los tiempos antiguos. ‘Los Anales de Roma nos cuentan’, dice él, ‘que en el año 480 ab U.C. el invierno era tan severo que destruyó los árboles’ […]. Muchos pasajes de Horacio suponen que las calles de Roma estaban cubiertas de nieve y hielo. Tendríamos más certeza respecto de este punto si los antiguos hubieran conocido el uso de los termómetros, pero sus escribas, sin intención, nos dan información suficiente para convencernos de que los inviernos en Roma son mucho más templados ahora que antes”. Hume ha extraído precisamente información derivativa a partir de alguna información primaria proporcionada por L’Abbe du Bos.

Volvamos ahora a nuestra pregunta: ¿puede haber información sin datos? La DGI no especifica qué tipos de datos constituyen información. Esta neutralidad tipológica (NTi, ver más arriba) está justificada por el hecho de que, cuando la aparente falta de datos no se reduce a la existencia de datos primarios negativos, lo que se vuelve disponible y que califica como información es cierta información adicional no-primaria μ acerca de σ constituida por ciertos datos no-primarios (D2)–(D5). Por ejemplo, si una consulta en una base de datos proporciona una respuesta, esta respuesta será al menos negativa, por ejemplo, “no se encontraron documentos”. En tal caso, ésta sería información primaria negativa. Sin embargo, si la base de datos no proporciona ninguna respuesta, pueden suceder dos cosas: o bien no es capaz de proveer datos en absoluto, en cuyo caso no hay ninguna información σ disponible –de modo que la regla “no hay información sin datos” todavía rige–, o bien es capaz de ofrecer algunos datos que permiten establecer, por ejemplo, que está corriendo en un loop [N. del T.: un loop es una secuencia que se repite una y otra vez, de manera continua]. Del mismo modo, el silencio –esta vez como respuesta a una pregunta– podría representar información primaria negativa, por ejemplo, como un asentimiento o una negación implícita; o bien podría portar cierta información no-primaria, por ejemplo, acerca del hecho de que la persona no ha escuchado la pregunta o acerca de la cantidad de ruido en la habitación.

1.6 Neutralidad ontológica ↑

Al rechazar la posibilidad de información sin datos, la DGI también acepta la modesta tesis de la neutralidad ontológica.

Neutralidad ontológica (NO):

No puede haber información sin representación de datos.

Siguiendo a Landauer y Bennet (1985), y Landauer (1987; 1991; 1996), la neutralidad ontológica (NO) a menudo se interpreta en términos materiales, como defendiendo la imposibilidad de la información sin soporte físico, a través de la ecuación “representación = implementación física”, esto es:

Cuando se trabaja en física de la computación, (NO.1) es un presupuesto inevitable ya que la ciencia de la computación debe, necesariamente, tomar en consideración las propiedades físicas y los límites de los portadores de datos. Por lo tanto, el debate en torno a (NO.1) ha florecido especialmente en el contexto de la filosofía de la información y computación cuántica (ver Deutsch 1985; 1997 y Di Vincenzo y Loss 1998; Steane 1998 ofrece un revisión). (NO.1) es también un presupuesto ontológico que está detrás de la Hipótesis de Sistemas de Símbolos Físicos en IA (Inteligencia Artificial) y en Ciencias Cognitivas. (Newell y Simon 1976). Pero (NO), y por lo tanto DGI, no especifica si, en última instancia, la aparición de todo estado discreto requiere una implementación material de las representaciones de datos. Presumiblemente, los entornos en los cuales todas las entidades, propiedades y procesos son en última instancia noéticos (e.g. Berkeley, Spinoza), o aquellos en los cuales el universo material o extenso tiene una matriz noética y no extensa como fundamento ontológico (e.g. Pitágoras, Platón, Descartes, Leibniz, Fichte, Hegel), parecen perfectamente capaces de sostener (NO) sin la necesidad de sostener (NO.1) de manera simultánea. Los correlatos en la DDD (más arriba) podrían ser los dedomena, tal como las mónadas leibnizianas, por ejemplo. De hecho, el clásico debate del realismo acerca de cuál es la naturaleza última del “ser” puede ser reconstruido en términos de las posibles interpretaciones de (NO).

Todas estas consideraciones explican por qué la DGI es también consistente con otros dos eslóganes muy populares, favorables a la naturaleza proto-física de la información y, por lo tanto, completamente contrarios a (NO.1):

Y también:

(NO.2) adopta una noción teórica de información, un monismo metafísico: la esencial naturaleza del universo es digital, está compuesta fundamentalmente de información en tanto datos/dedomena en lugar de materia o energía, donde los objetos materiales son una compleja manifestación secundaria (recientemente, una posición similar ha sido defendida en física por Frieden (1998), cuyo trabajo está basado en una perspectiva platónica inexacta). Sin embargo, (NO.2) puede no verse obligado a comprometerse con un punto de vista computacional de los procesos de información. (NO.3) defiende un enfoque más pluralista en términos similares. Y ambos son compatibles con DGI.

Podemos introducir un comentario final sobre (DGI.3) al discutir un cuarto eslogan:

(NO.4) es una de las primeras y más populares formulaciones de la DGI (ver por ejemplo Franklin 1995, 34 y Chalmers 1996, 281). Habitualmente, la formulación se atribuye a Mackay (1969) (aunque no se ha encontrado en este texto) –esto es, “información es una distinción que hace una diferencia” –que precede a la formulación de Bateson aunque es ligeramente diferente de ella, ya que habla de “distinción” en lugar de “diferencia”, lo cual le da un giro más epistemológico y no tan ontológico. Una “diferencia” (una “distinción”) es sólo un estado discreto, a saber, un dato; y “hacer una diferencia” significa simplemente que el dato es “significativo”, al menos potencialmente.

1.7 Neutralidad Genética ↑

Finalmente, consideremos la naturaleza semántica de los datos. El tema de cómo los datos pueden llegar a tener un significado asignado y una función en un sistema semiótico constituye en primer lugar uno de los problemas más difíciles de la semántica. Afortunadamente, el punto en cuestión aquí no es cómo sino si acaso los datos que constituyen información como contenido semántico pueden ser significativos independientemente de un informado. La neutralidad genética (NGe), apoyada por la DGI, afirma que:

Neutralidad Genética (NGe):

Los datos (como correlatos) pueden tener una semántica independientemente de cualquier informado.

Antes del descubrimiento de la Piedra Roseta, los jeroglíficos egipcios ya eran considerados como información, aun cuando su semántica estuviese más allá de la comprensión de cualquier intérprete. El descubrimiento de una interfaz entre el griego y el egipcio no afectó la semántica de los jeroglíficos, sino solamente su accesibilidad. Este es el sentido condicional-contrafáctico débil en el que (DGI.3) se refiere a datos significativos arraigados en portadores de información, con independencia de un informado. La NGe apoya la posibilidad de la información sin un sujeto informado, para usar una frase popperiana. El significado no está (o, al menos, no está únicamente) en la mente del usuario. Hay que distinguir la NGe de la tesis realista más fuerte que defiende, por ejemplo, Dretske (1981). De acuerdo con esta tesis, los datos podrían también tener su semántica propia, independientemente de un informador/productor inteligente. Esto es conocido como información ambiental, un concepto que merece una breve presentación antes de finalizar esta primera parte.

1.7.1 Información ambiental ↑

Uno de los ejemplos más citados de información ambiental es el de los anillos concéntricos que se ven en la madera de un tronco de árbol que ha sido cortado, y que se pueden usar para estimar su edad. Sin embargo, la información “ambiental” no necesariamente debe ser natural. Volviendo a nuestro ejemplo anterior, cuando uno enciende el auto con la llave, la luz roja del indicador de batería baja se prende. Esta señal también puede interpretarse como una instancia de información ambiental, sin ser natural.

La información ambiental se define en relación con un observador (un agente de información) que, se supone, no tiene acceso directo a los datos puros en sí mismos. Se requiere que dos sistemas a y b estén acoplados de tal manera que el que a sea (del tipo de, o en el estado) F esté correlacionado con el que b sea (del tipo de, o en el estado) G, y que así lleve la información al observador de que b es G (este análisis está adaptado de Barwise y Seligman (1997), quienes mejoran un abordaje similar ofrecido por Dretske 1981).

Información ambiental:

Dos sistemas, a y b, están acoplados de manera tal que el que a sea (del tipo de, o en el estado) F, esté correlacionado con el que b sea (del tipo de, o en el estado) G, transmitiéndole así al agente la información de que b es G.

La correlación aludida es usualmente nómica, es decir, sigue alguna ley. Puede tratarse de un producto de ingeniería, como en el caso del indicador de baja batería (a) cuyo brillo (F) está desencadenado por el hecho de que la batería (b) está descargada (G) y, por lo tanto, es informativo acerca de ello. Pero también puede ser natural, como cuando se usa tornasol (un colorante natural de los líquenes) como un indicador de acidez y alcalinidad, pues se vuelve rojo en las soluciones ácidas y azul en las alcalinas. Otros ejemplos típicos incluyen la correlación entre las huellas digitales y la identificación personal.

Puede suceder que uno esté tan acostumbrado a ver el indicador de batería baja encendido como algo que lleva información acerca de que la batería está descargada, que resulta difícil distinguir, con claridad suficiente, entre información ambiental y semántica. Sin embargo, es importante enfatizar que la información ambiental puede no requerir o no involucrar semántica en absoluto. La información ambiental puede consistir en (redes o patrones de) datos correlacionados, entendidos como meras diferencias o posibilitadores limitantes (“constraining affordances" en el original). Las plantas (por ejemplo, un girasol), los animales (por ejemplo, una ameba), y los mecanismos (por ejemplo, una célula fotoeléctrica) son ciertamente capaces de hacer un uso práctico de la información ambiental, incluso sin que haya (procesamiento semántico de) datos significativos.

1.8 Resumen de la primera parte ↑

Para resumir, la DGI define la información, en un sentido amplio, como datos sintácticamente bien formados y significativos. Los cuatro tipos de neutralidad (NTa, NTi, NO y NGe) representan una ventaja obvia, en tanto hacen que la DGI sea perfectamente extrapolable a casos más complejos, y razonablemente flexible en términos de aplicabilidad y compatibilidad. De hecho, los filósofos han interpretado y ajustado de diversas formas estas cuatro neutralidades de acuerdo con sus necesidades teóricas.

Nuestro siguiente paso es examinar si acaso la DGI resulta satisfactoria cuando se discute el tipo más importante de información semántica, esto es, la información acerca de hechos (información factual). Antes de abordar este asunto, sin embargo, necesitamos detenernos y ocuparnos de la teoría matemática de la comunicación (TMC).

La TMC no es el único enfoque matemático exitoso del concepto de información. La información de Fisher (Frieden 2004) y la teoría algorítmica de la información (Chaitin 1987) son otros dos ejemplos importantes. En cualquier caso, la TMC es ciertamente la más conocida entre los filósofos. Como tal, ha tenido un impacto profundo en los análisis filosóficos de la información semántica, a los cuales ha aportado tanto el vocabulario técnico como también un primer marco conceptual de referencia. Para comprender el debate filosófico que suscita es necesario comprender la esencia de la teoría.

2 La información como comunicación de datos ↑

Algunas características de la información son intuitivas. Estamos acostumbrados, por ejemplo, a que la información sea codificada, transmitida y almacenada. Además, esperamos que sea aditiva (es decir, que información a + información b = a + b) y no-negativa, como otras cosas en la vida, tal como las probabilidades y las tasas de interés. Si hace una pregunta, el peor escenario es aquél en el que no recibe respuesta o recibe una respuesta errónea, lo cual lo dejará en un estado de cero información nueva.

Algunas propiedades similares de la información son cuantificables y son investigadas por la teoría matemática de la comunicación (TMC) con el objetivo de generar modos eficientes de codificar y transferir datos.

El nombre de esta rama de teorías probabilísticas surge del trabajo seminal de Shannon (Shannon and Weaver 1949). Shannon fue pionero en este campo y obtuvo muchos de sus principales resultados, pero reconoció la importancia del trabajo previo llevado a cabo por otros investigadores y colegas en Bell Laboratories, donde se destacan Nyquist y Hartley (ver Cherry 1978 y Mabon 1975). Después de Shannon, la TMC se popularizó como la teoría de la información, una atractiva pero desafortunada etiqueta, que continúa indefinidamente causando malos entendidos. Shannon llegó a lamentar la amplia popularidad de la etiqueta, y aquí evitaremos usarla.

La segunda parte de este artículo esboza algunas de las ideas claves detrás de la TMC, con el objetivo de comprender la relación que hay entre la TMC y algunas de las teorías filosóficas de la información semántica. Aquellos lectores que no sean afectos a las fórmulas matemáticas, preferirán ir directamente a la sección 2.2, donde se esbozan algunas implicaciones conceptuales de la TMC. En cambio, los lectores que estén interesados en profundizar su conocimiento, pueden comenzar leyendo Weaver (1949), Pierce (1980), Shannon y Weaver (1949 rep. 1998), luego Jones (1979), y finalmente Cover y Thomas (1991). Los últimos dos son textos técnicos. Floridi (2010) ofrece un análisis breve y simplificado orientado a estudiantes de filosofía.

2.1 La teoría matemática de la comunicación ↑

La TMC se originó en el campo de la ingeniería electrónica como el estudio de los límites de la comunicación, desarrollando un enfoque cuantitativo de la información como una manera de dar respuesta a dos problemas fundamentales: cuál es el nivel último de compresión de datos (¿cuán pequeño puede ser un mensaje dada la misma cantidad de información a codificar?) y cuál es la tasa última de transmisión de datos (¿cuán rápido pueden transmitirse los datos por un canal?). Para ambos problemas, las soluciones son la entropía H en la ecuación [9] (ver más abajo) y la capacidad del canal C. El resto de la sección ilustra cómo obtener soluciones para los dos problemas.

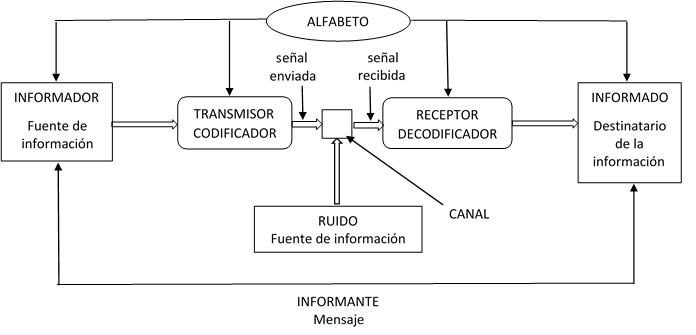

Para comenzar con una aproximación intuitiva al enfoque, volvamos a nuestro ejemplo. Recordemos la conversación telefónica con el mecánico. En la Figura 3, la esposa es la informadora, el mecánico es el informado, “la batería está descargada” es el mensaje (semántico), es decir, el informante. Además, hay un proceso de codificación y decodificación a través del lenguaje natural (español), un canal de comunicación (el sistema de teléfono) y algún posible ruido. Informador e informado comparten alguna clase de conocimiento común acerca de la colección de símbolos que son utilizados (técnicamente, esto es conocido como el alfabeto; en el ejemplo es el alfabeto latino).

La TMC se ocupa del uso eficiente de los recursos que están indicados en la Figura 3. Ahora bien, la conversación con el mecánico es bastante realista y, por lo tanto, más difícil de modelar que un caso simplificado. Volveremos a esto más adelante pero, en vistas a introducir la TMC, imaginemos en lugar del ejemplo del mecánico, un dispositivo muy aburrido que solamente puede producir un único símbolo. Edgar Alan Poe escribió un breve cuento en el cual un cuervo solo podía responder “nunca más” a cualquier pregunta. El cuervo de Poe es llamado un dispositivo unario. Imagine que llama al mecánico y quien responde su llamado es el cuervo de Poe. Incluso a este nivel elemental, el modelo simple de comunicación de Shannon se aplica. Es obvio que el cuervo (un dispositivo unario) produce cero cantidades de información. Simplificando, nosotros ya sabemos cuál será la respuesta en el intercambio comunicativo, por lo que nuestra ignorancia (expresada por nuestra pregunta) no puede decrecer. Sea cual sea el estado informacional en el que el sistema esté, hacer las preguntas pertinentes (e.g. ¿seré capaz de encender mi auto?, ¿puede venir a arreglar el auto?) al cuervo no le hace ninguna diferencia. Es interesante notar que esto está a la base del famoso argumento de Platón en el Fedro contra el valor de la información semántica provista por textos escritos:

“[Sócrates]: Escribir, Fedro, tiene esta extraña cualidad, muy similar a la pintura: las criaturas de las pinturas parecen seres vivos, pero si uno les hace una pregunta, ellas permanecen en un solemne silencio. Y lo mismo sucede con las palabras escritas; podríamos pensar que ellas hablan, como si tuviesen inteligencia, pero si las interrogas, deseando saber acerca de lo que dicen, ellas siempre dicen una misma y única cosa [ellas son dispositivos unarios, en nuestra terminología]. Y toda palabra [275e] una vez escrita, se pone de moda igualmente para quienes la entienden y para quienes no están interesados en ella, y ella no sabe a quién hablarle y a quién no; cuando es maltratada o injustamente injuriada siempre necesita de un padre que la defienda, ya que no tiene poder para protegerse a sí misma.”

Como bien advierte Platón, un recurso unario responde siempre con un único mensaje, no con un silencio o un mensaje, ya que el silencio cuenta también como mensaje, como dijimos en 1.5 cuando se discutió la naturaleza de la información secundaria. Lo que se sigue de esto es que una fuente en completo silencio también califica como una fuente unaria. Y si silenciar una fuente (censura) puede ser una forma sucia de hacer a una fuente no-informativa, es bien conocido que gritar “¡lobo!” es un caso clásico en el cual una fuente informativa se degrada al papel de un dispositivo unario no-informativo.

Consideremos ahora un dispositivo binario capaz de producir dos símbolos, como una moneda justa con sus dos símbolos equiprobables {h, t} [N. del T.: las letras “h” y “t” corresponden al inglés “head” y “tail”, que serían la cara y ceca de una moneda. Como en español ambas empiezan con la misma letra, se decidió dejarlo como estaba en el original]; o, como Mateo 5,37 sugiere: “Que este sea vuestro hablar: sí, cuando sea sí; no, cuando sea no; cualquier cosa de más, proviene del demonio”. Antes de que la moneda sea lanzada, el informado (por ejemplo, una computadora) está en un estado de déficit de datos mayor a cero: el informado no sabe qué símbolo producirá el dispositivo. Shannon utilizó el término técnico de “incertidumbre” para referirse a este déficit de datos. En un contexto no matemático, esto puede ser un término un poco engañoso, ya que tiene fuertes connotaciones epistemológicas. Recuérdese que el informado puede ser una simple máquina, por lo que estados doxásticos, mentales o psicológicos son claramente irrelevantes.

Una vez que la moneda ha sido lanzada, el sistema produce una cantidad de información que es una función de los posibles resultados, en este caso, dos símbolos equiprobables, e igual al déficit de datos que elimina.

Construyamos ahora un sistema ligeramente más complejo, compuesto de dos monedas A y B. El sistema AB puede producir los siguientes cuatro pares ordenados como resultado: <h, h>, <h, t>, <t, h>, <t, t>, lo cual genera un déficit de datos de cuatro unidades, donde cada par es considerado como un símbolo en el alfabeto de la fuente. En el sistema AB, la aparición de cada símbolo <_,_> elimina una mayor cantidad de déficit de datos que la aparición de un símbolo en el sistema A. En otras palabras, cada símbolo provee mayor información. Agregar una moneda más produciría ocho unidades de déficit de datos, incrementando la cantidad de información que cada símbolo contiene en el sistema ABC, y así sucesivamente.

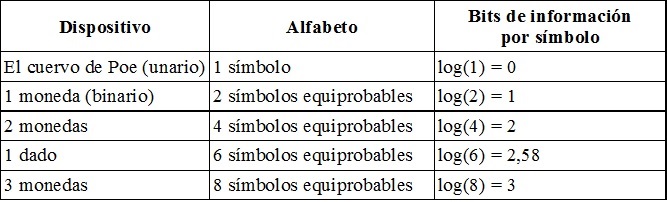

Estamos en condiciones de generalizar los ejemplos. Llamemos N al número de símbolos posibles. Para N = 1, la cantidad de información producida por un dispositivo unario es 0. Para N = 2, al producir un símbolo equiprobable, el dispositivo envía una unidad de información; y para N = 4, al producir un símbolo equiprobable, el dispositivo envía la sumatoria de la cantidad de información producida por un dispositivo que produce uno de dos símbolos equiprobables (la moneda A en el ejemplo anterior) más la cantidad de información producida por otro dispositivo que también produce uno de dos símbolos equiprobables (moneda B), esto es, dos unidades de información, aunque el número total de símbolos es obtenido al multiplicar los símbolos de A por los símbolos de B. Ahora, nuestra medida de información debe ser una función continua y monótona de la probabilidad de los símbolos. La manera más eficiente de satisfacer estos requerimientos es utilizando el logaritmo en base 2 del número de posibles símbolos (el logaritmo en base 2 de un número n es la potencia a la cual 2 debe ser elevado para obtener n, por ejemplo log2 8 = 3, ya que 23 = 8). Los logaritmos tienen la ventajosa propiedad de convertir la multiplicación de símbolos en una suma de unidades de información. Tomando el logaritmo en base 2 (en adelante, log simplemente significa log2), tenemos la ventaja extra de expresar las unidades en bits. La base del logaritmo es parcialmente una cuestión convencional, de la misma manera que utilizar centímetros en lugar de pulgadas; en parte porque es útil cuando tratamos con dispositivos digitales que utilizan códigos binarios para representar datos.

Dado un alfabeto de N símbolos equiprobables, ahora podemos utilizar la ecuación [1]:

[1] El promedio de informatividad por símbolo (o “incerteza”) = log2(N) bits de información por símbolo.

Para repasar algunos ejemplos de manera más precisa:

La idea básica está contenida completamente en la ecuación [1]: la información puede cuantificarse en términos del decrecimiento en el déficit de datos (la “incertidumbre” de Shannon). Desafortunadamente, las monedas reales siempre están sesgadas, y para calcular cuánta información producen ellas, uno debe basarse en la frecuencia con que aparecen los símbolos en una serie finita de tiradas, o en sus probabilidades si las tiradas se realizan una cantidad indefinida de veces. Comparada con una moneda justa, una moneda con un ligero sesgo produce menos de 1 bit de información, aunque todavía produce más que 0. El cuervo de Poe no produjo información en absoluto, ya que la ocurrencia de la cadena S de “nunca más” fue no informativa (es decir, no causa sorpresa, para utilizar el vocabulario más intuitivo, aunque psicologista, de Shannon), y esto se debe a que la probabilidad de la aparición de “nunca más” fue máxima, es decir, demasiado predecible. Igualmente, la cantidad de información producida por una moneda sesgada depende de la informatividad promedio (también conocida como sorpresa promedio, otro término desafortunado para referirse a la rareza estadística promedio) de la cadena S de los h y t producidos por la moneda. La informatividad promedio de la cadena resultante S depende de la probabilidad de la aparición de cada símbolo. Cuánto más alta sea la frecuencia de aparición de un símbolo en S, menor es la cantidad de información producida por la moneda, hasta el punto en que una moneda está tan sesgada que produce siempre el mismo símbolo y deja de ser informativa en absoluto, comportándose como el cuervo o el niño que grita “¡lobo!”.

Por lo tanto, para calcular la informatividad promedio de S necesitamos calcular S y la informatividad de cada símbolo ith en general. Para hacer estos cálculos necesitamos entender cuál es la probabilidad de aparición (Pi) del símbolo ith, y esta probabilidad Pi puede extraerse de la ecuación [1] que está embebida en log(N), un caso especial en el cual los símbolos son equiprobables. Utilizando algunas propiedades elementales de la función logaritmo, obtenemos:

[2] log(N) = −log(N −1) = −log(1/N) = −log(P)

El valor de 1/N = P tiene un rango de 0 a 1. Si el cuervo de Poe es nuestra fuente, la probabilidad de decir “buen día” es 0. En el caso de la moneda, P(h) + P(t) = 1, no importa cuán sesgada esté la moneda. La probabilidad es como un pastel que puede ser rebanado en porciones cada vez más pequeñas dependiendo del número de invitados, pero que nunca crece más allá de su tamaño original y, en el peor de los escenarios, que puede ser igual a cero pero nunca ser negativo. En términos más formales, esto puede expresarse de la siguiente manera:

N

[3] ∑ Pi = 1

i=1

La sigma mayúscula de la notación en [3] es, simplemente, una atajo que indica que si sumamos todas las probabilidades de i = 1 a i = N, la sumatoria será igual a 1.

Ahora estamos en condiciones de precisar el ejemplo del cuervo de Poe: “nunca más” no es en absoluto informativo porque Pnunca mas = 1. Claramente, mientras más baja sea la probabilidad de aparición de un símbolo, mayor será la información ante una aparición de hecho. La informatividad u del símbolo ithpuede expresarse por analogía con −log(P) en la ecuación [4]:

[4] ui = −log(Pi)

A continuación, necesitamos calcular el largo de una cadena general S. Supongamos que la moneda sesgada es lanzada diez veces, produciendo la cadena: <h, h, t, h, h, t, t, h, h, t>. El largo de la cadena S (que en nuestro caso es = 10) es igual al número de veces que aparece el tipo de símbolo h, sumado al número de veces que aparece el tipo de símbolo t:

Generalizando para i tipos de símbolos:

N

[5] S = ∑ Si

i=1

Si unimos las ecuaciones [4] y [5], vem

Es una interpretación de un sistema axiomático que hace verdaderos a todos los axiomas, y por lo tanto a todas las fórmulas, del sistema.